多模态增强现实交互原型设计(PICO字节跳动实习

-

项目来源于本人在PICO字节跳动暑期实习内容。本次实习中,我的工作是对一款可穿戴混合现实产品以及其配件开发交互原型并验证交互体验。本人一共在工作中承担了四部分的工作:

1.产品情景挖掘

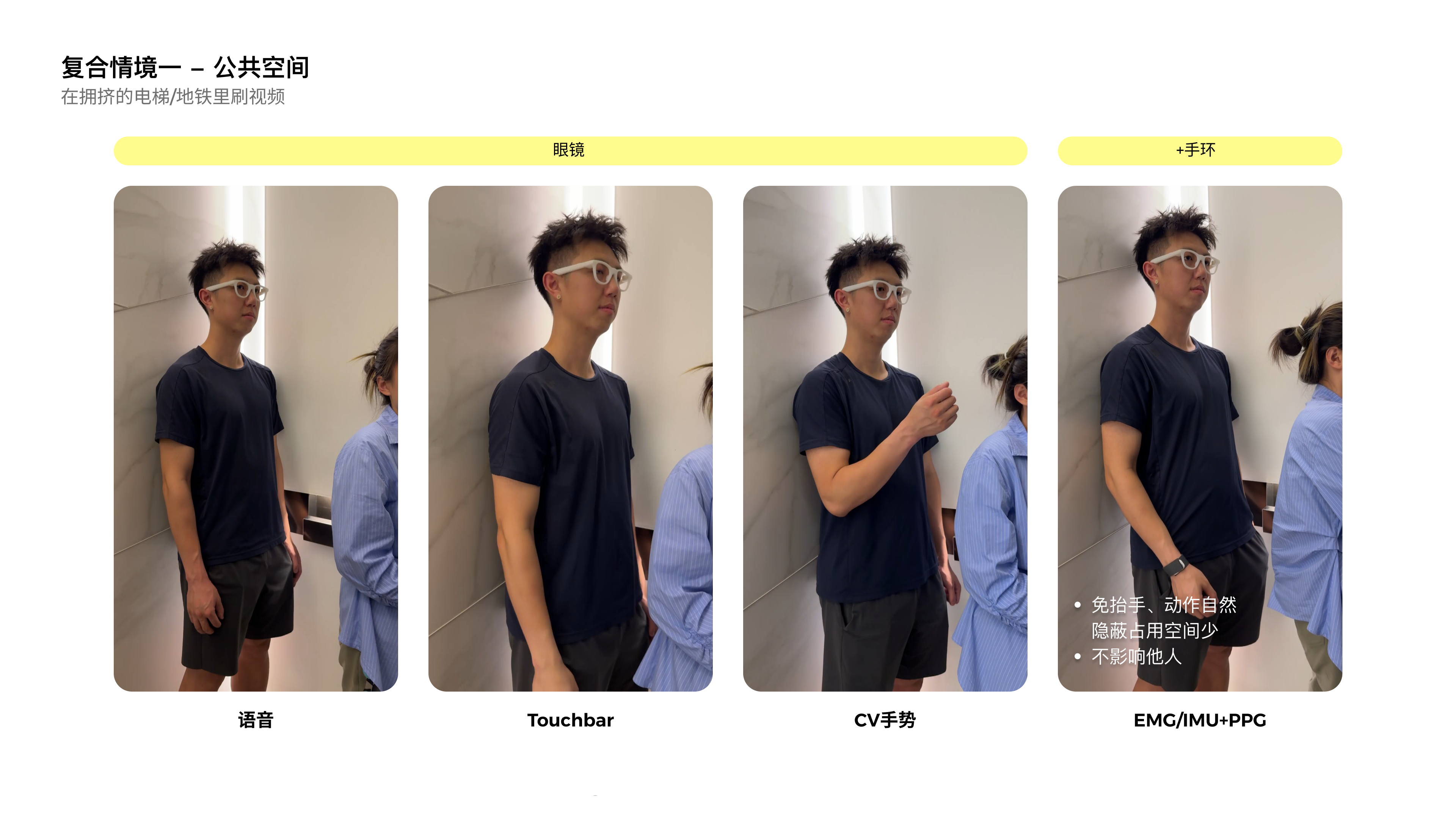

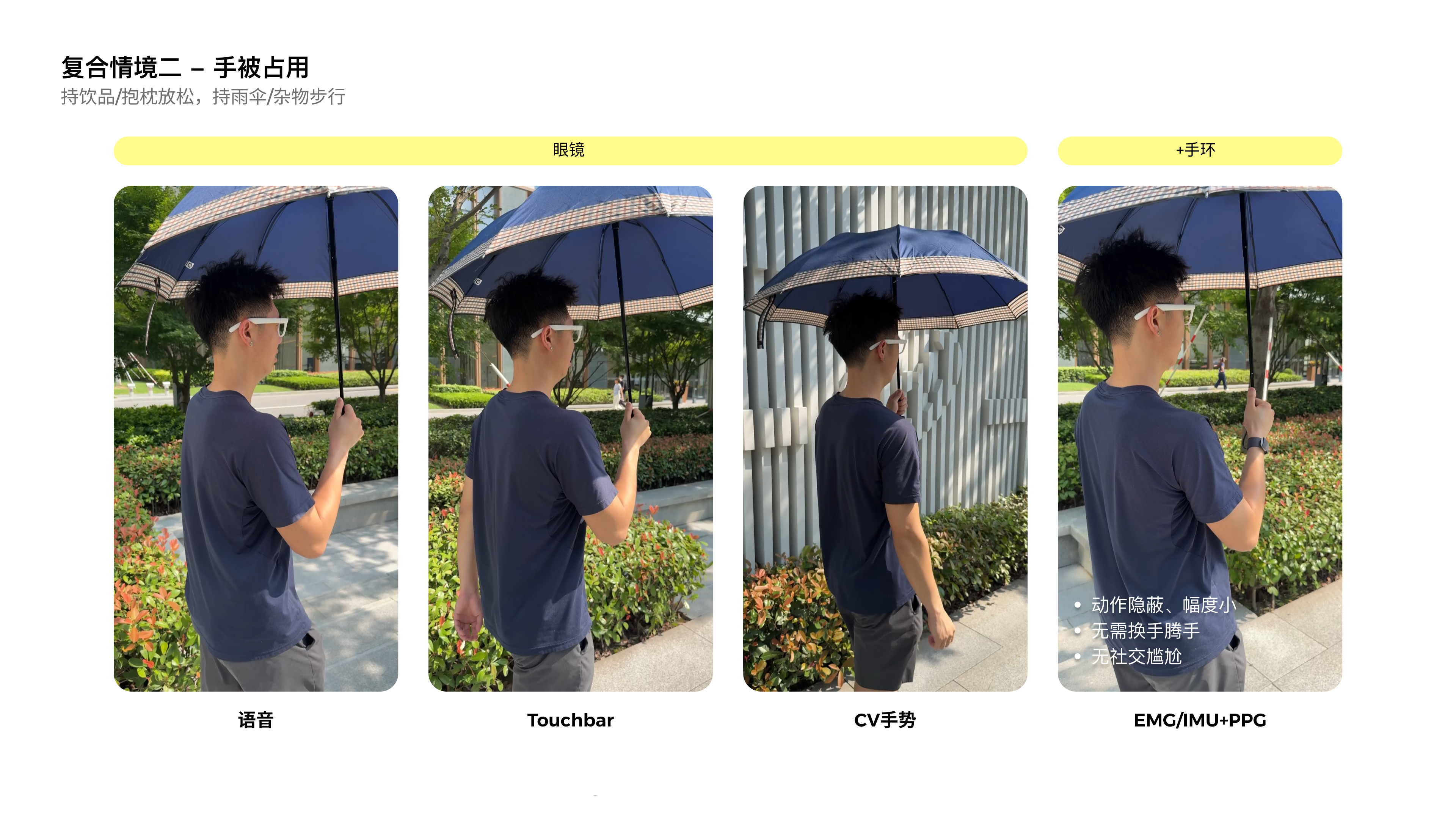

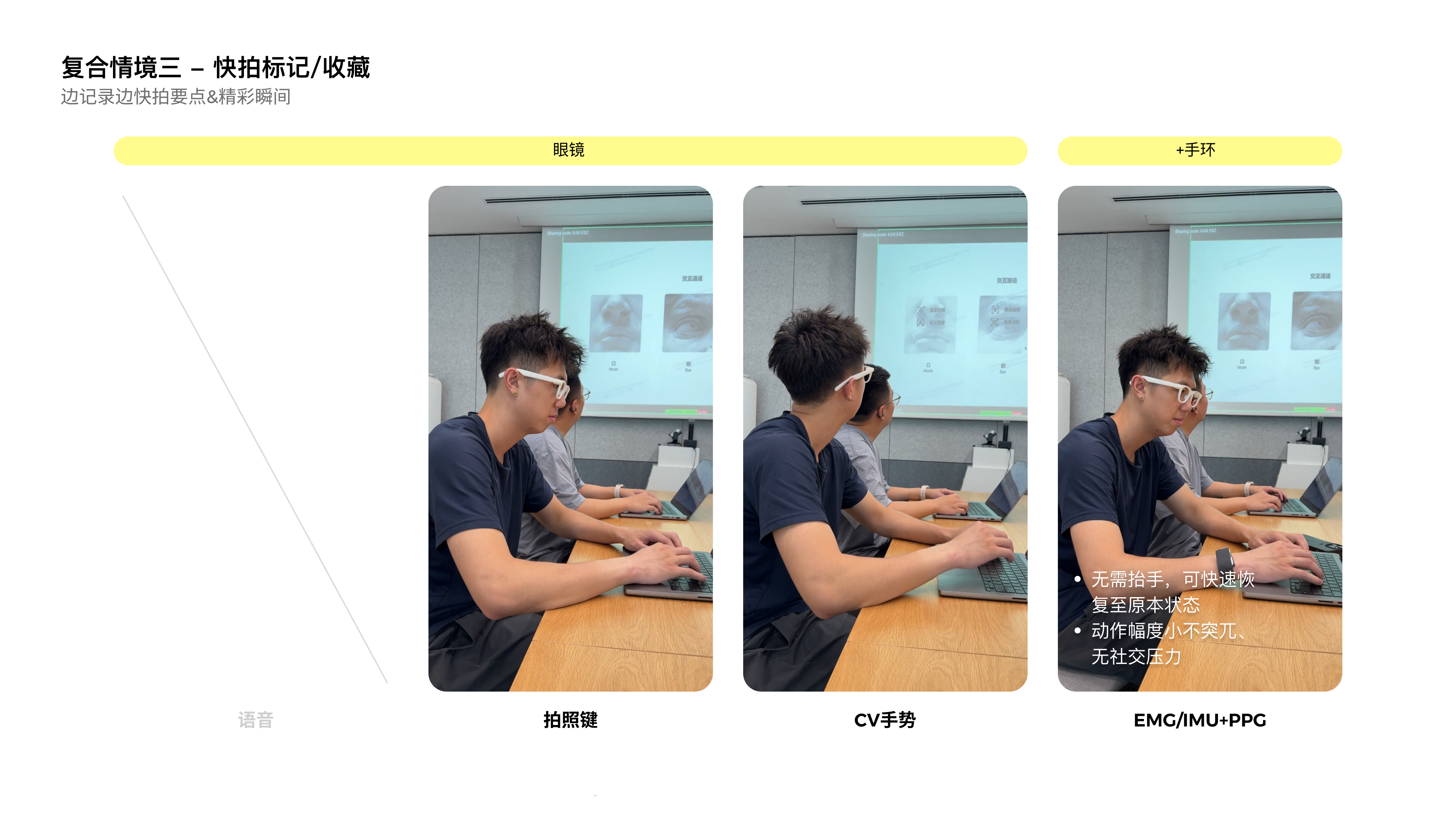

针对该可穿戴产品以及配件的主交互,我开展了日记式挖掘,对用户可能存在的交互行为按照日程时间顺序进行频率和重要性的评估,通过构建了一个熵增算法遴选出在频率或在重要性上显著的事件。并筛选出那些在频率或重要性并不显著,但在交互体验上有独特性的事件作为产品的主要场景。

2.多模态交互原型开发

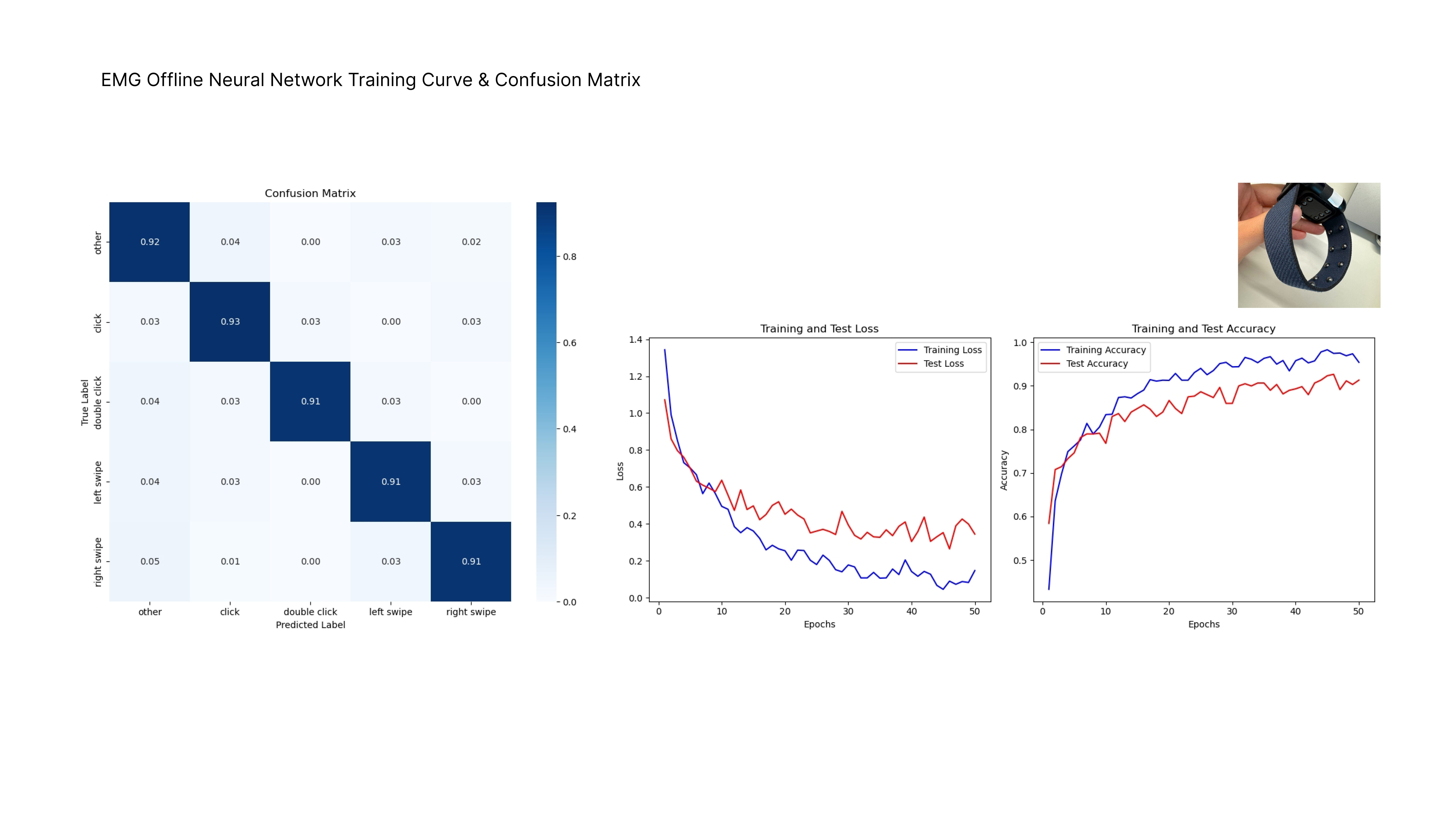

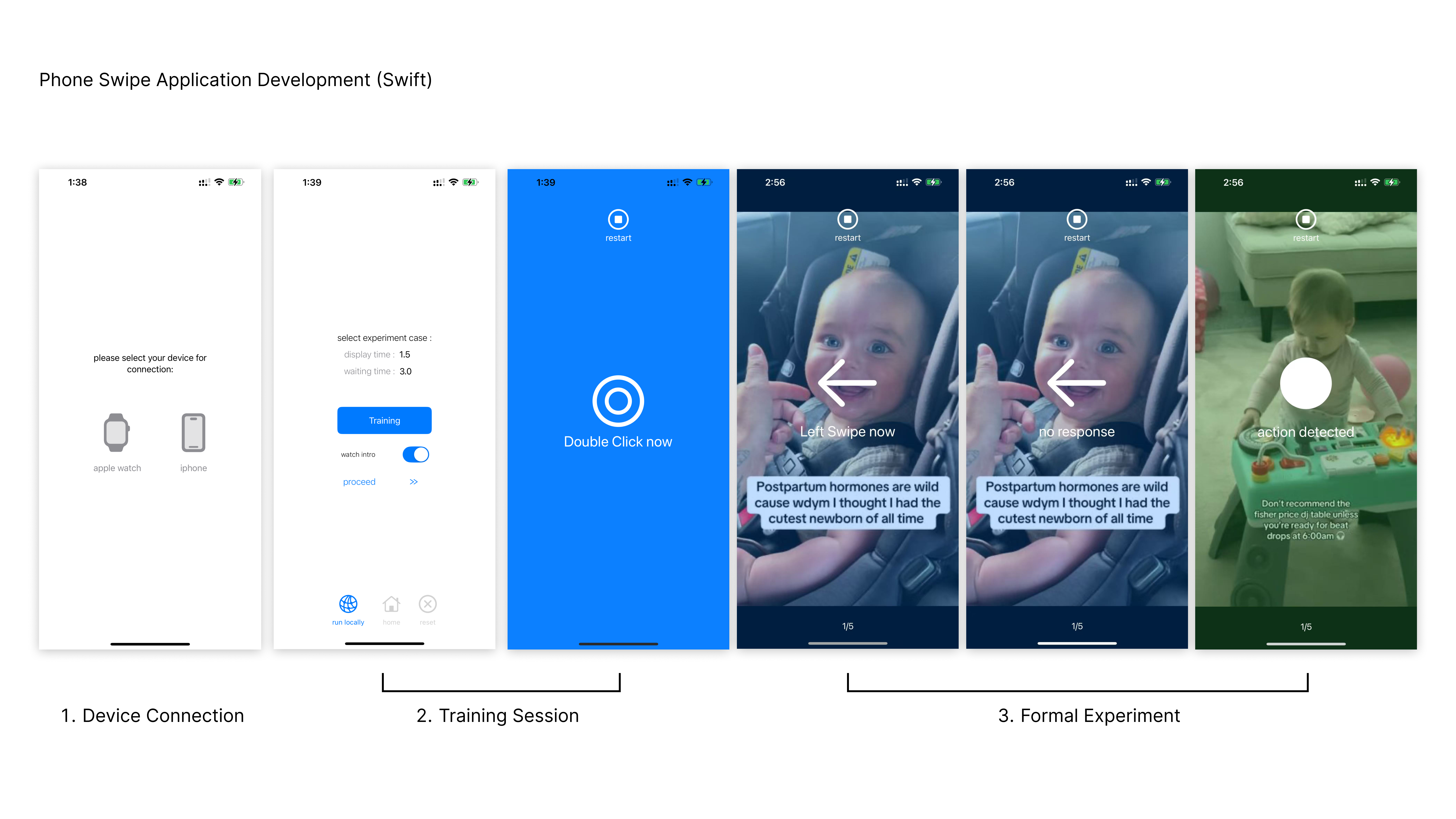

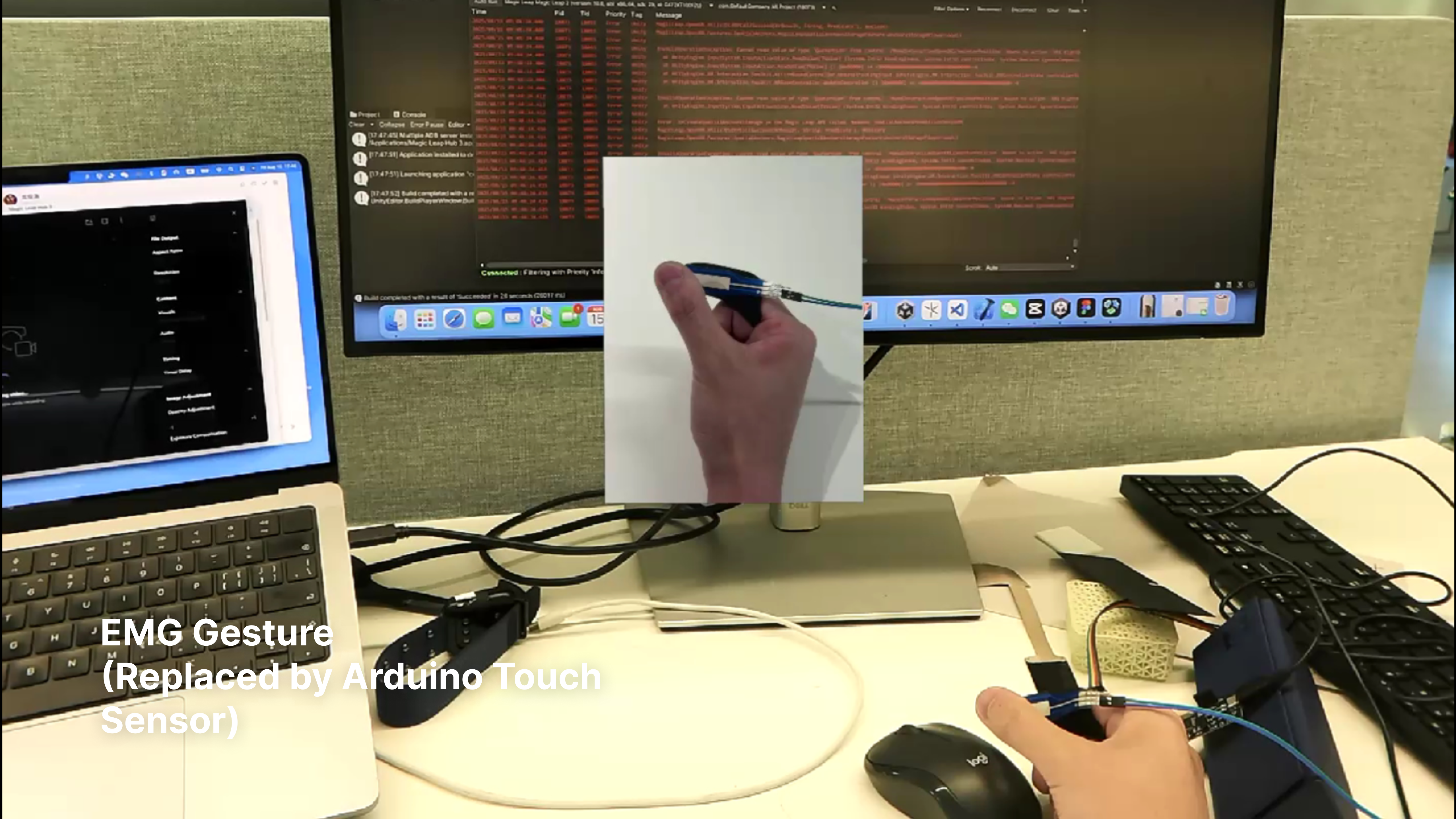

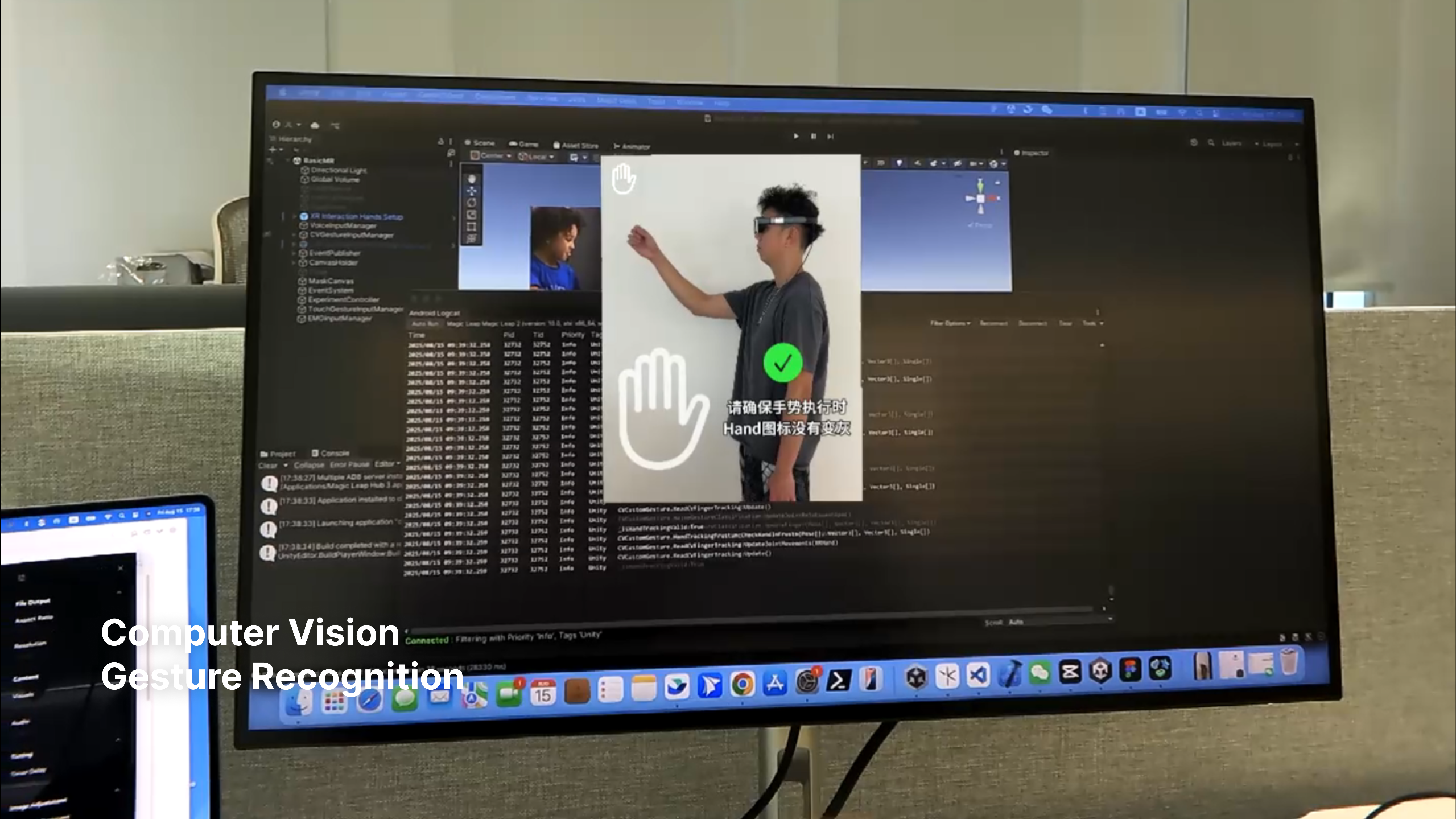

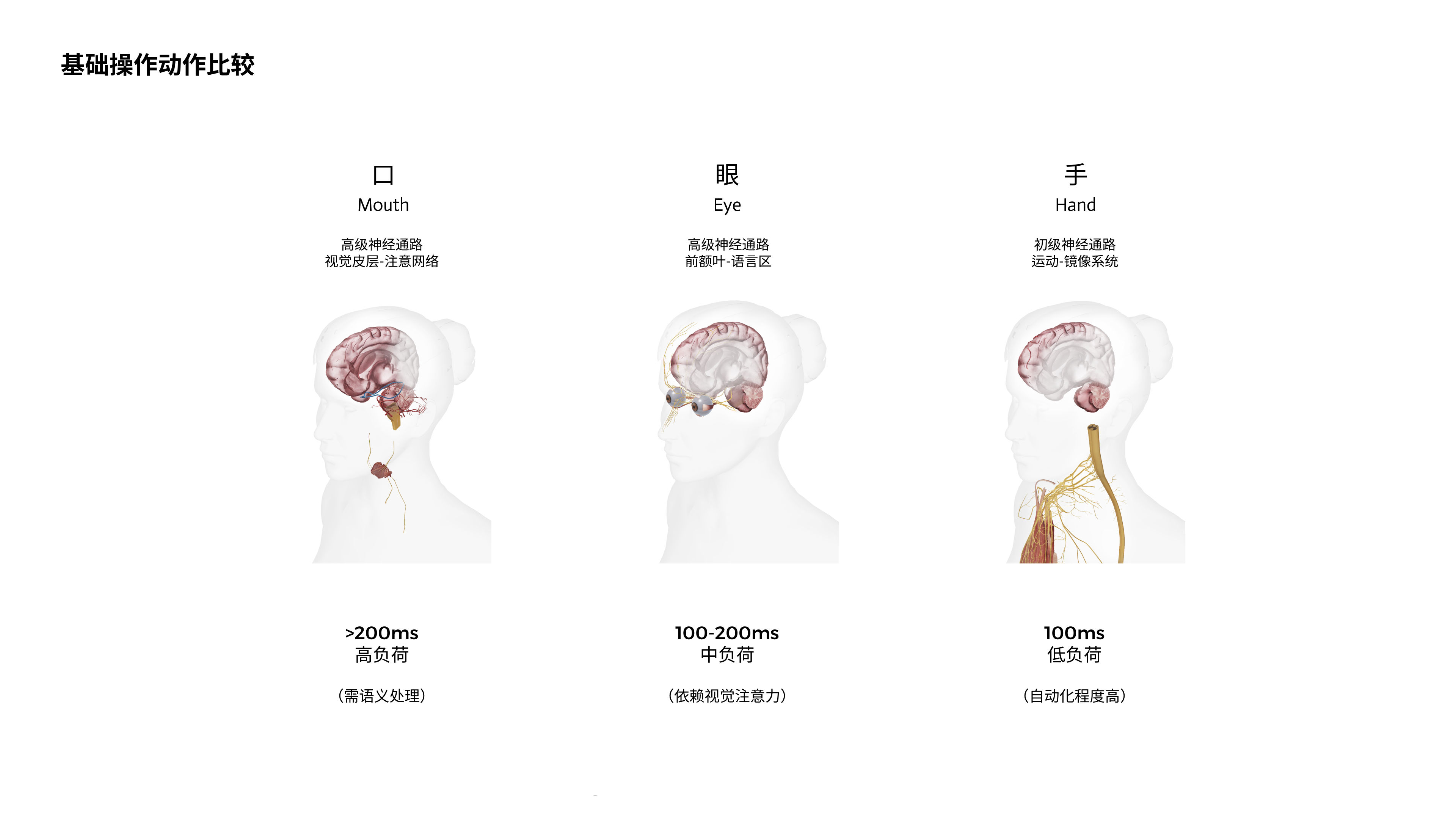

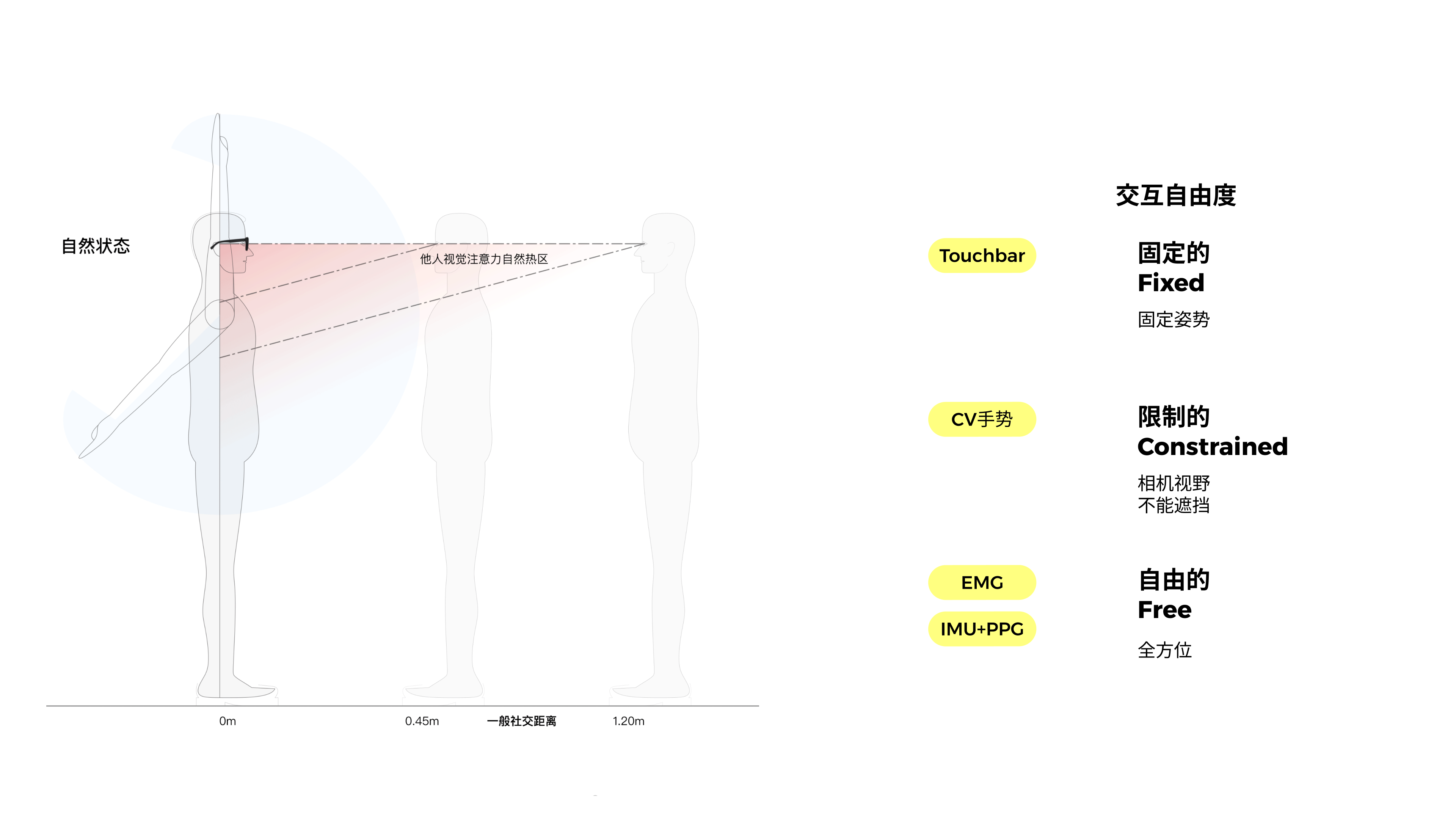

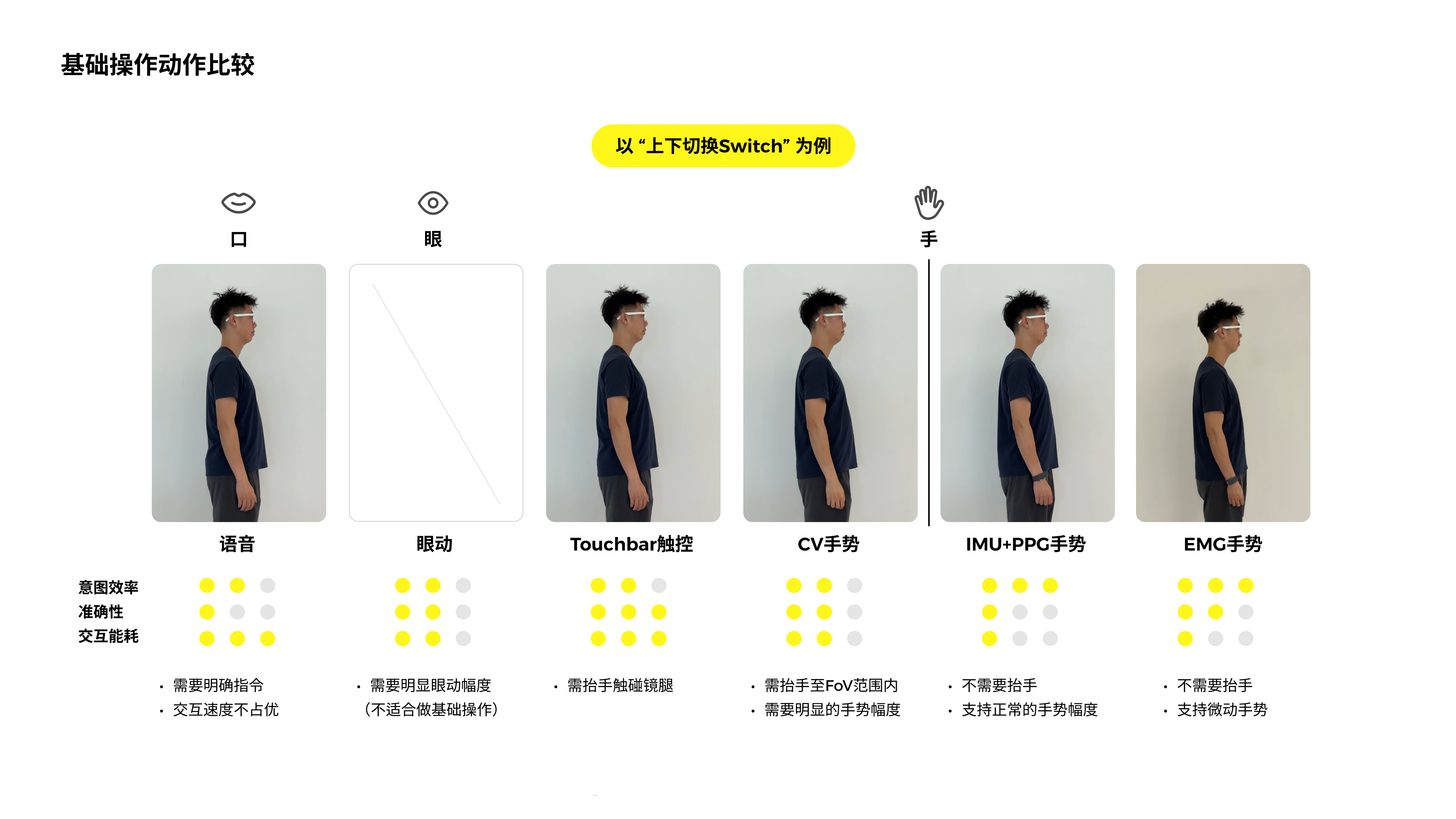

本人针对手机滑动(基线交互),触摸滑条交互,计算机视觉手势识别,EMG手势识别以及语音交互搭建了多模态的交互原型。主要的项目难点在于计算机视觉手势识别针对不同个体的泛化性不足,触摸滑条没有硬件基础以及EMG手势识别的基础模型没有建立。针对计算机视觉手势识别针对不同个体的泛化性不足的问题,我们综合关节识别+规则约束的方法,在时间占比和幅度占比上同时约束手势模式,实现了92%以上的识别成功率。针对EMG手势识别的基础模型没有建立的问题,我们首先尝试了两种方式:

A. 小型数采并进行简单的5个手势的识别;

B.将设备通道和采样率插值与重采样,fit进meta的开源模型,进行实时识别。

但前两种方式的效果并不能达到工业级别,尽管在离线识别任务中,EMG能够达到92%左右的正确率,但是在实时分类任务中,几乎都是错误的,可能归因在于数据集不足覆盖实时交互的场景。第二条方法误识别的情况也很多。因此,我们采用了Arduino压力传感器的方式对手势进行了定义,实现对EMG的模拟。

3.增强现实+AI原型开发

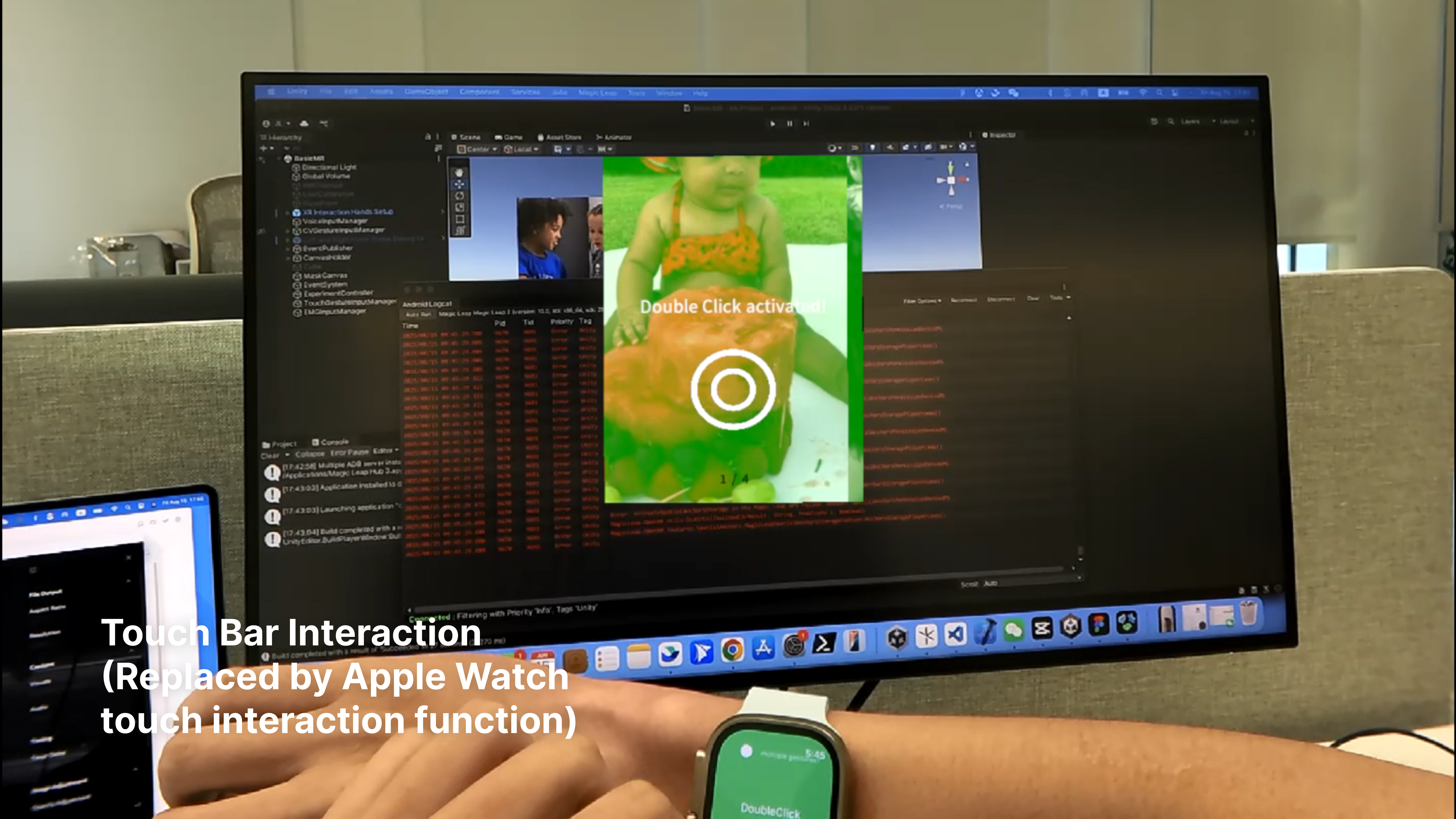

针对第2步进行的多模态输入通道,我与搭档进行了增强现实上的AI交互原型的开发。我们调用了Magic Leap2的原生speaker,将原始音源输入豆包API实现文字识别,调用Magic Leap2的场景相机,给予Android程序调用抖音app的权限,实现了以关键词方式触发的功能。解决了Magic Leap2本身只支持英文语音交互的问题。

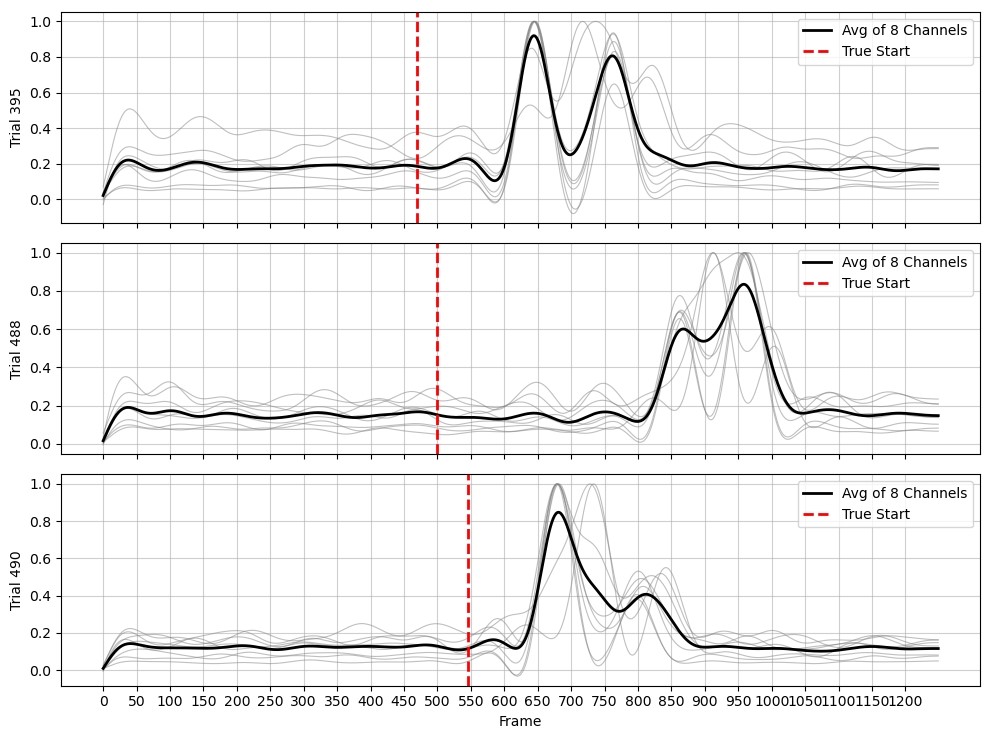

4.EMG小型手势数据采集以及模型训练

我们在字节跳动公司内部采集了15人一共6000条5种手势数据。对手势真实起点,我们采用了Expectation-Maximization的方式进行求解,将事件手势时间戳更精确地对齐到真实手势开始时间戳。通过复现meta的一层CNN,三层LSTM模型,配合论文中提到的梯度调节方式,实现了离线分类正确率大于92%的结果。

一.多模态交互原型

二.增强现实+AI交互原型

-

设计类型: 多模态交互,AI交互,手指追踪,EMG分类,混合现实交互

项目类型:PICO字节跳动暑期实习

时间: 2025.5-2025.8

指导:Ennin Huang、Biliang Wang

主要贡献:

1.融合 Python、C# 与 Swift,打通 Magic Leap、iOS、Windows 三端交互,集成语音、CV/EMG 手势、眼动与 Touch Bar多模态输入接口,实现统一事件机制与验证体系;

2.基于计算机视觉算法训练 5 类手势识别模型,通过优化算法规则与参数,识别准确率提升 7%;

3.采集 15 名被试共 6,000 条 EMG 手势样本,复现 Meta 模型训练流程,构建轻量 CNN+LSTM 模型,实现离线识别准确率 95%.

技能:Deep Learning, Machine Learning, Bio-signal Processing, Python, PyTorch, Swift, Unity, WebSocket