虚拟现实中的感觉运动控制

-

项目是本人在佐治亚理工NeuroLoops实验室的主持项目。实验目的是对手部运动感觉控制过程进行量化建模,并利用实时机器学习模型进行行为预测,以期在飞镖动作完成前能实现对成绩的预测,从而施加适当的纠正刺激来帮助用户适应学习过程。本研究主要涉及三部分内容:多模态硬件设备设计、实时预测模型建立、虚拟现实闭环交互系统设计。

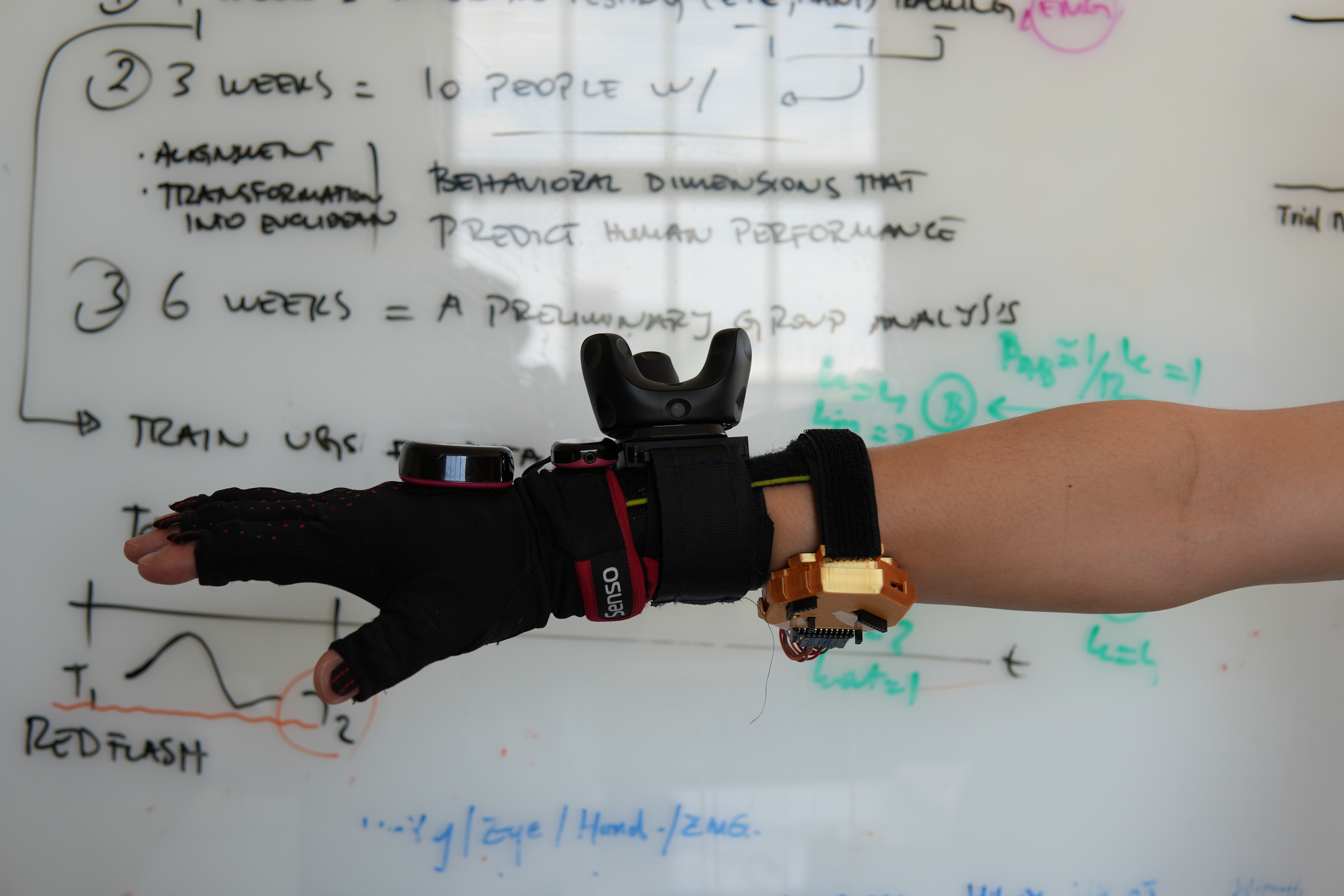

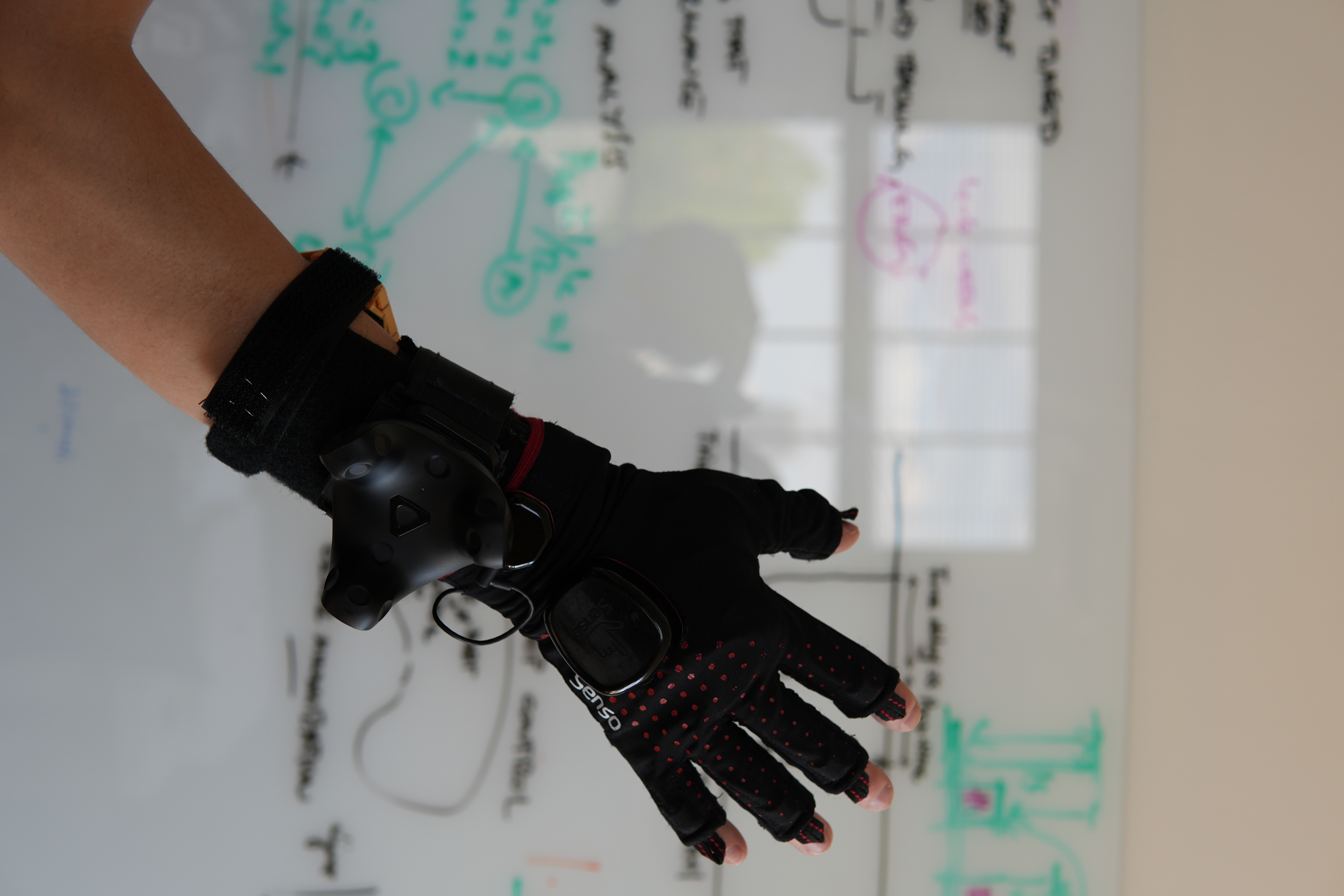

1.多模态硬件设备设计

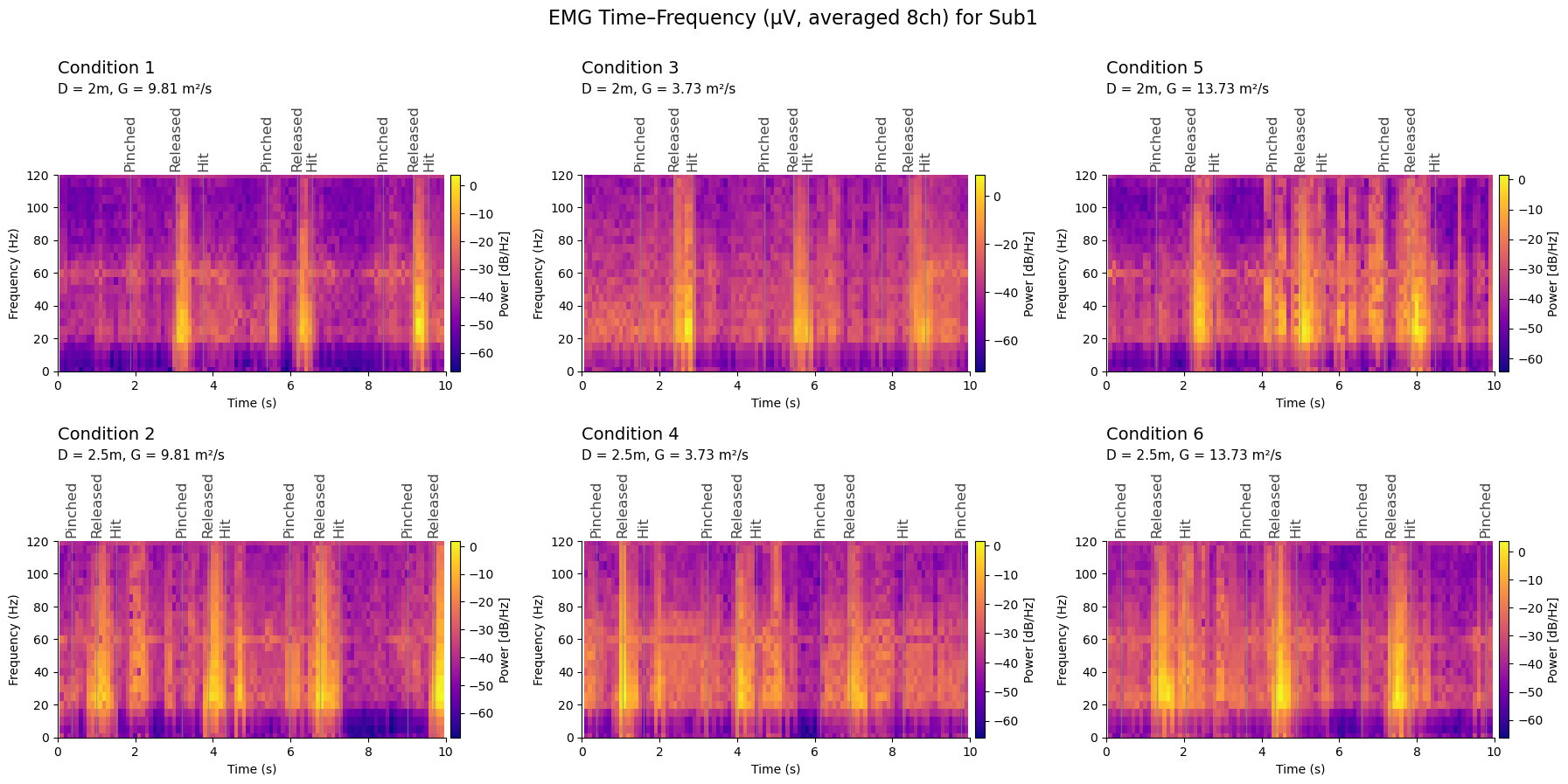

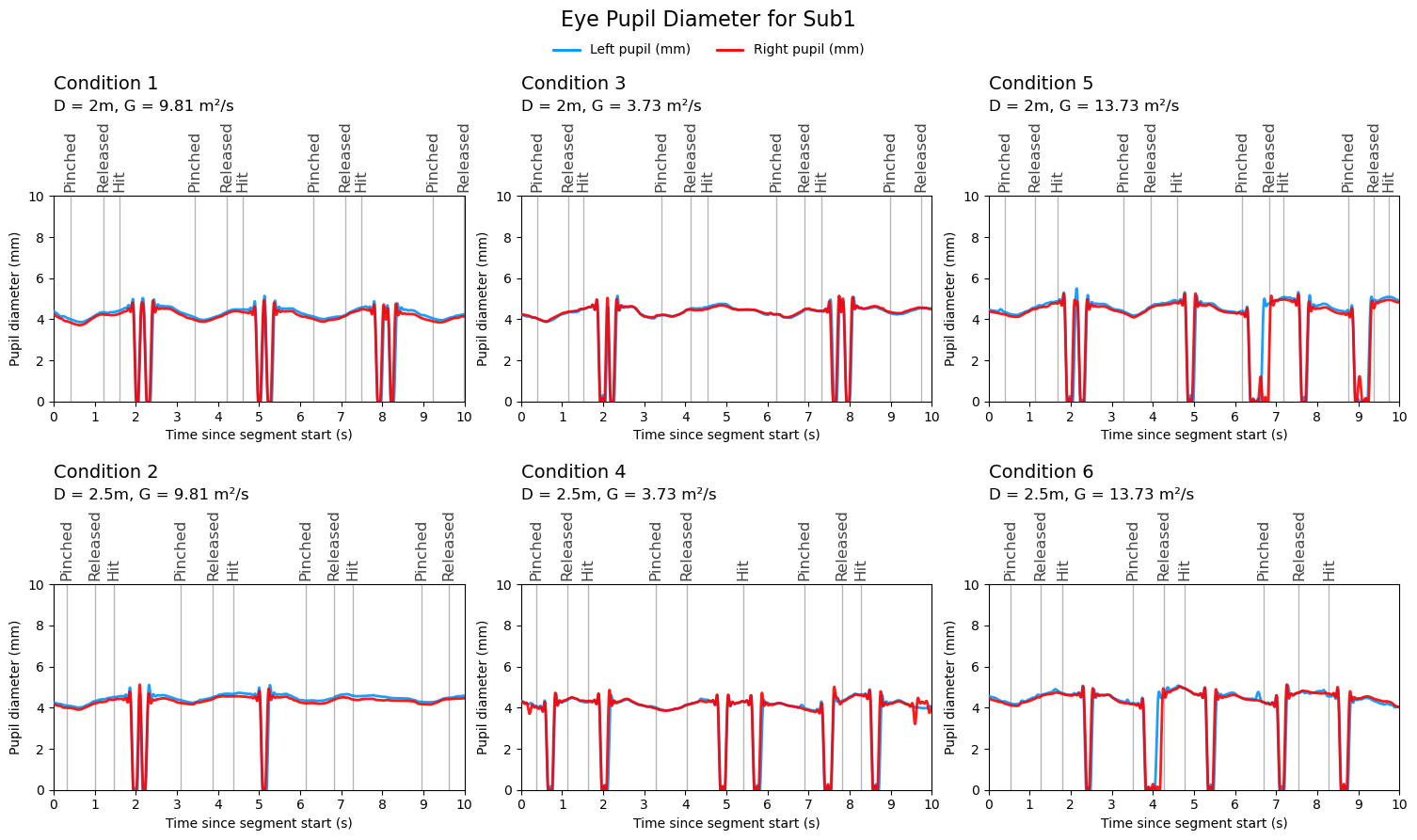

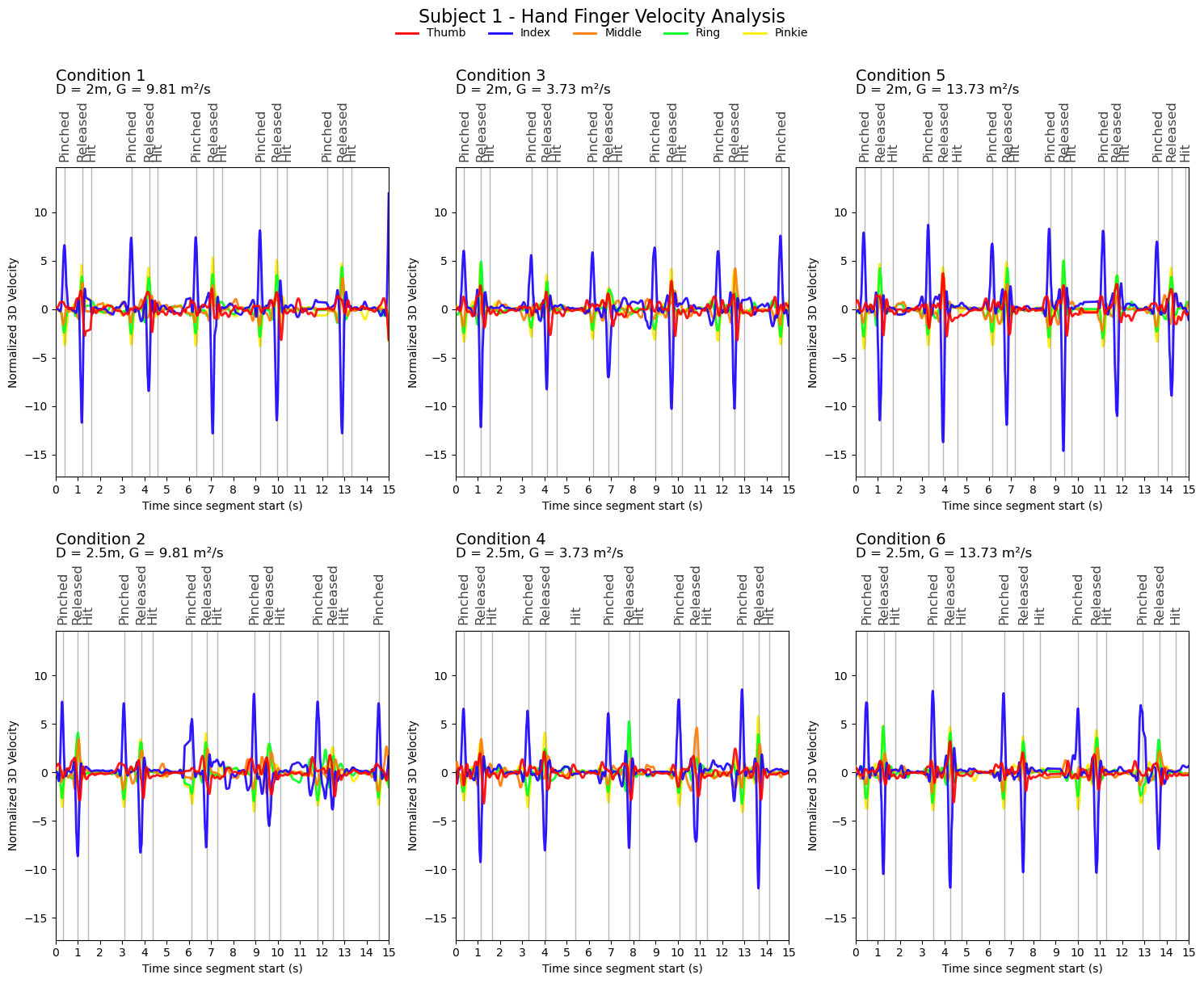

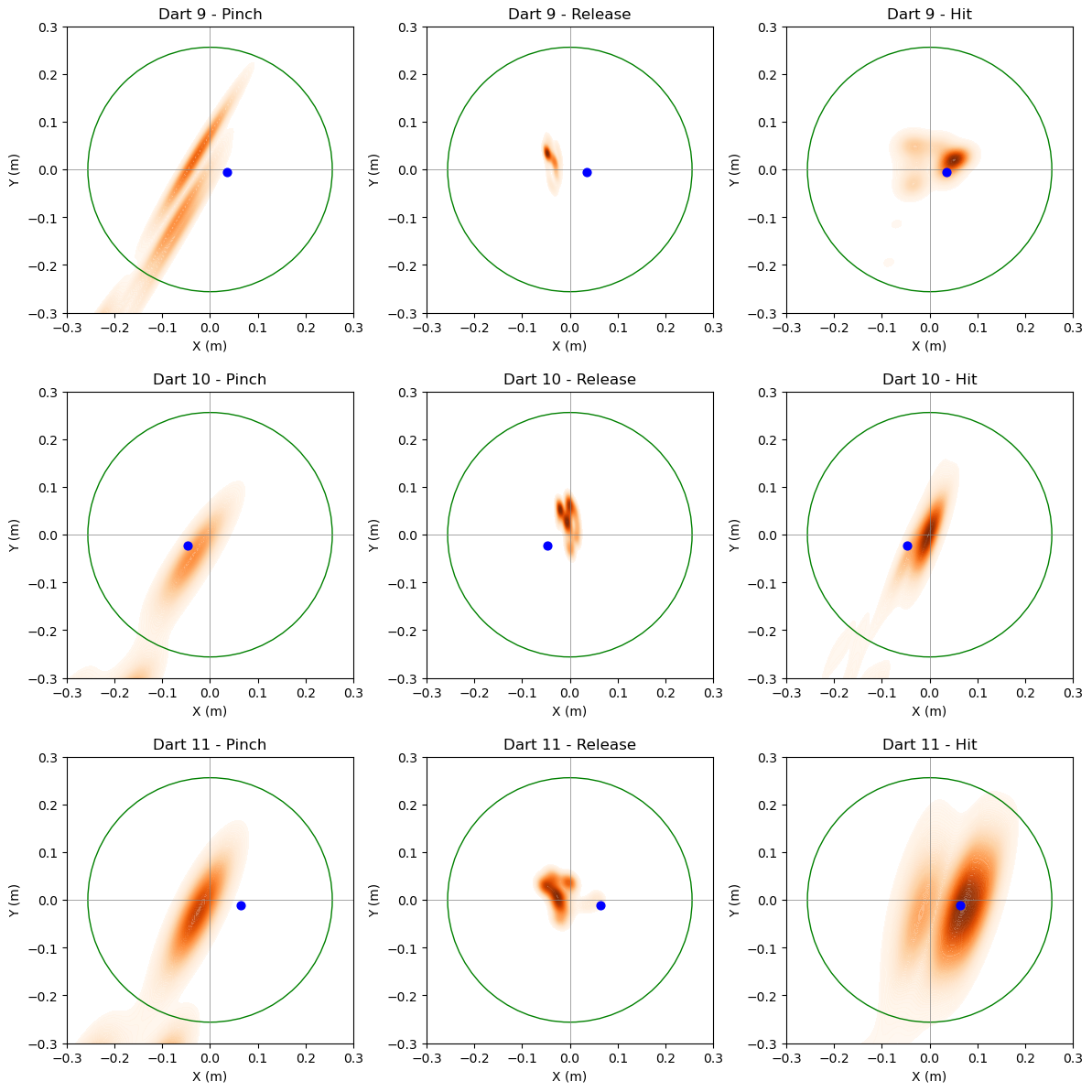

我们利用senso.me手套配合Valve tracker来定位手指关节所在的世界坐标,放弃使用计算机视觉的原因主要在于快速移动过程当中的预测抖动以及动作在CV相机范围外的问题无法被解决。同时我们自己开发并制作了一款16通道的EMG腕表来收集手腕屈肌的EMG神经信号。同时我们记录了在VR里用户的眼球位置、瞳孔大小、头部位置等来建立行为模型。

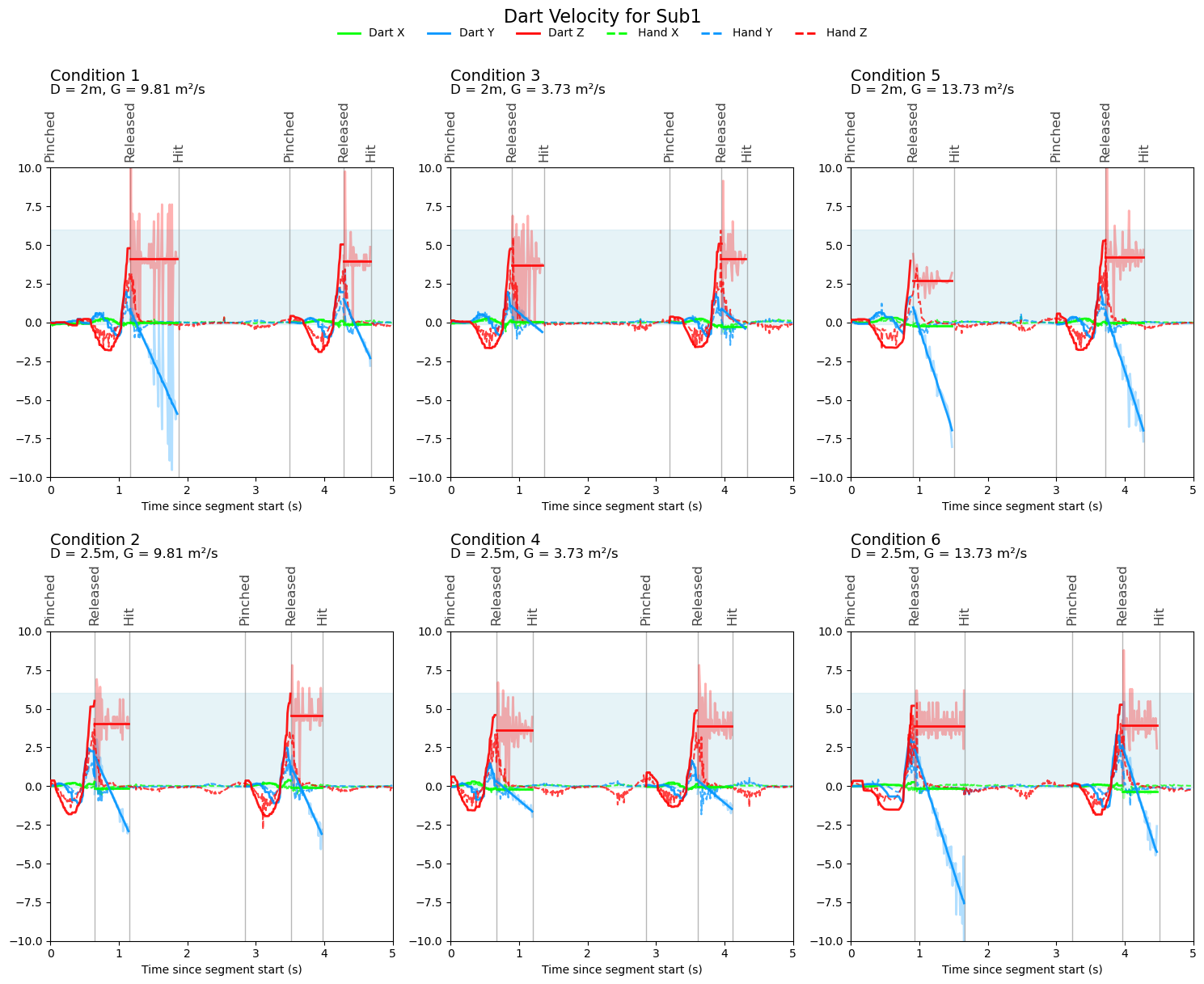

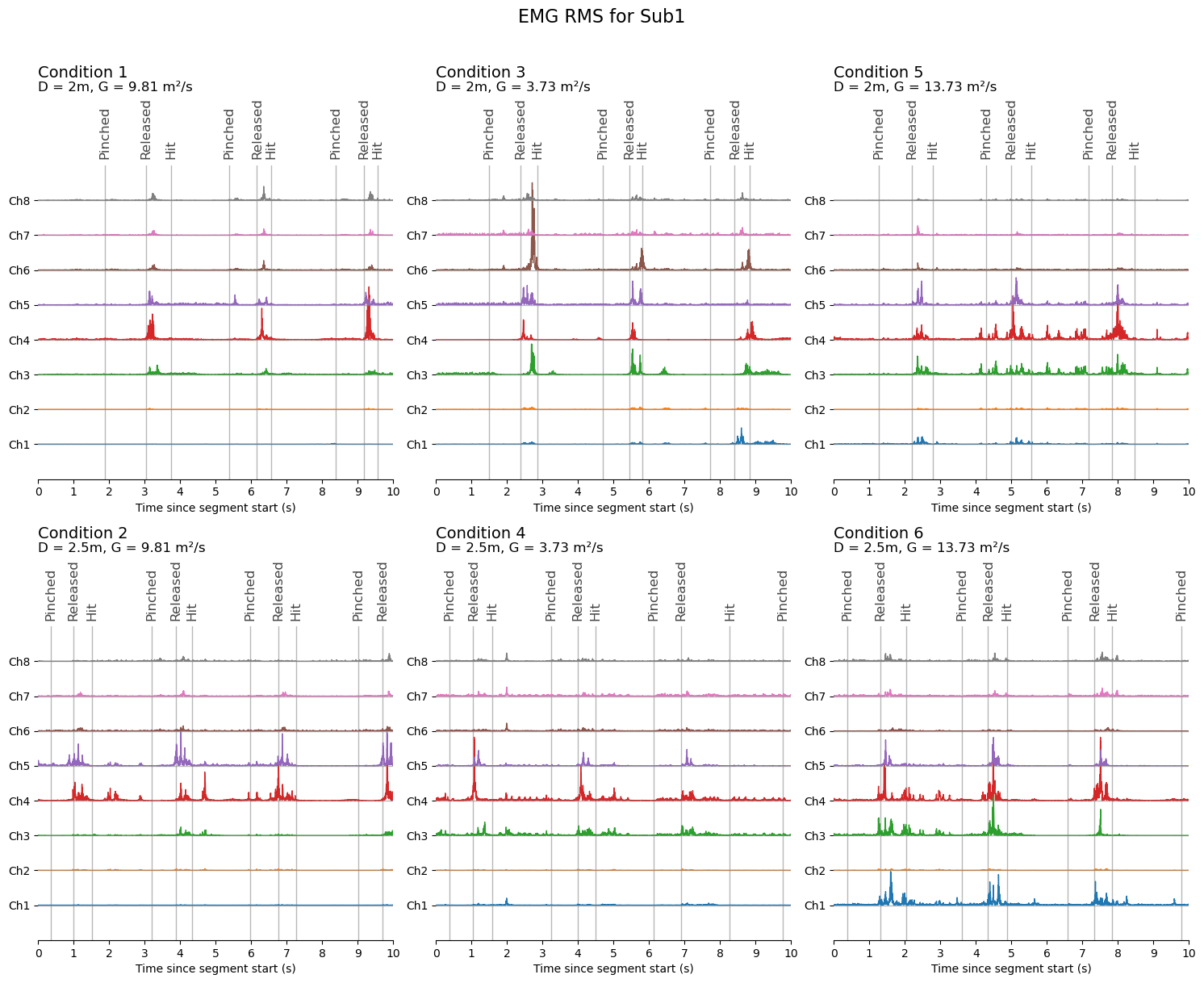

2.实时预测模型建立

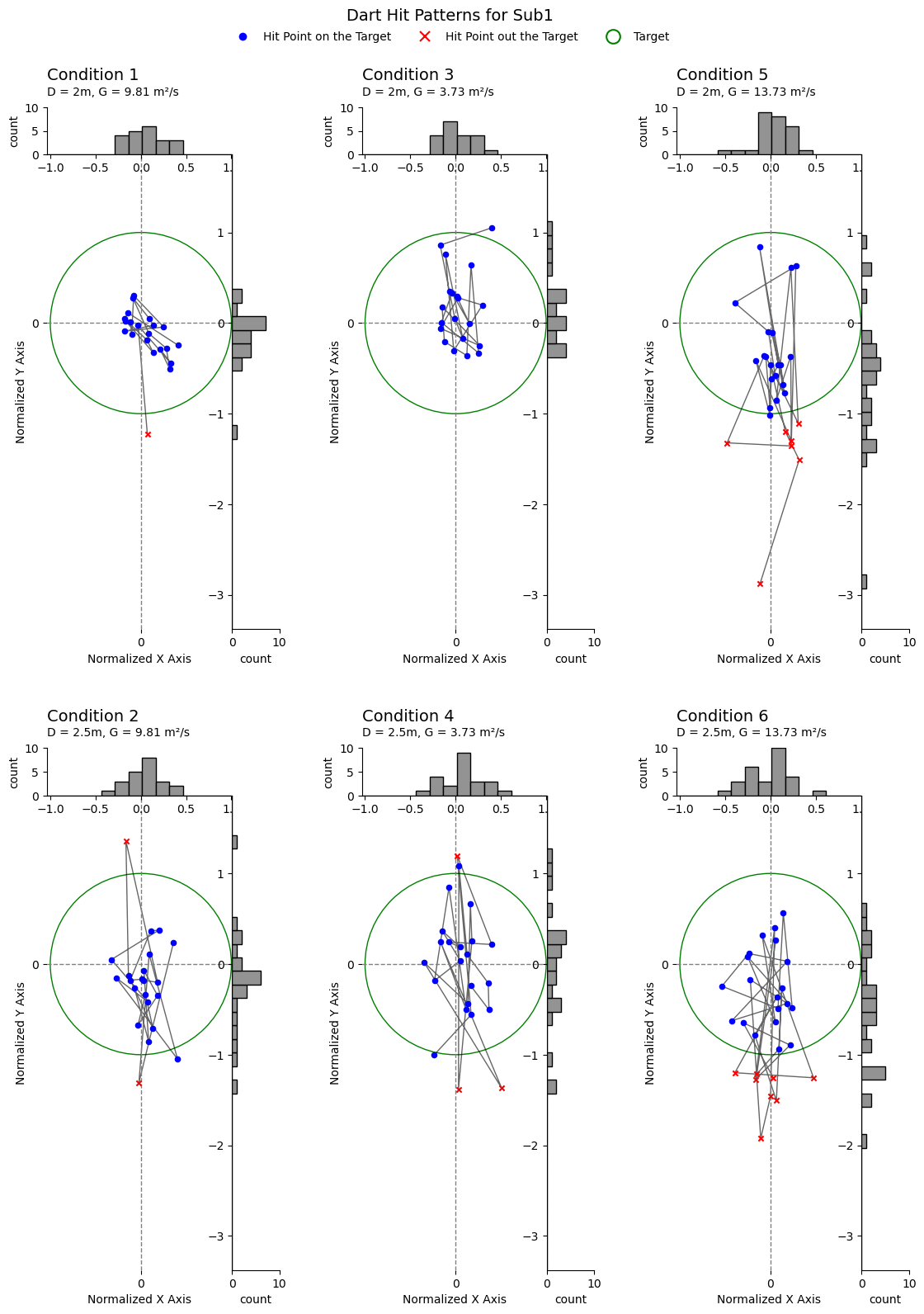

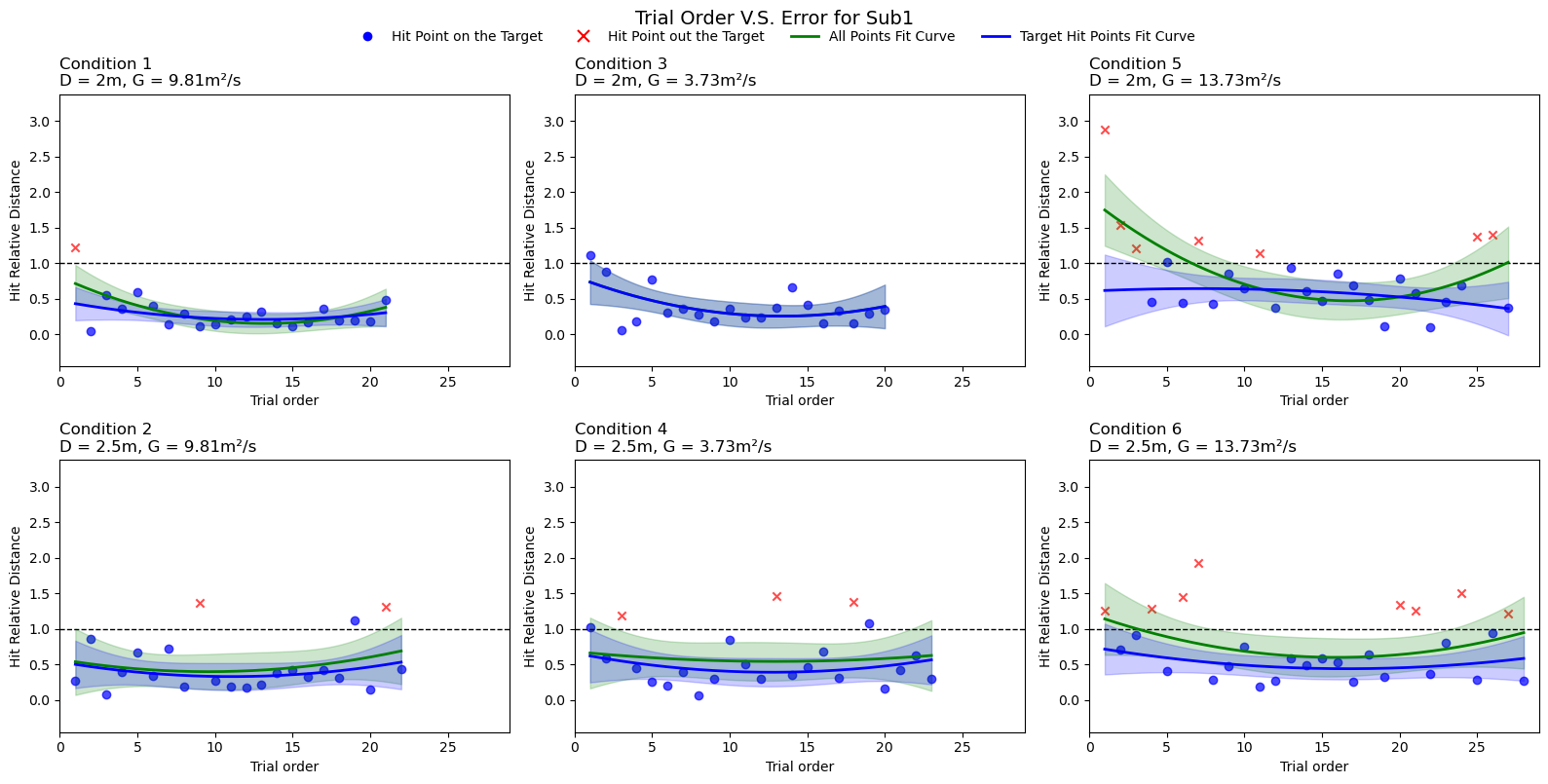

我们针对125人采集了30min的运动表现数据(针对6项变量),利用PCA进行特征降维,CNN卷积进行时间特征降维,最后配合3层LSTM模型进行飞镖释放时间的预测。

3.虚拟现实闭环交互系统设计

我们针对眼动行为进行了纠正,在上一次结果的基础上提供一个纠正向量来帮助用户进行学习。此外我们可视化了实时预测出的抛物曲线来帮助用户学习。

-

关键词: 脑机接口、虚拟现实、人机交互、泛在计算

项目类型:佐治亚理工NeuroLoops实验室主持项目

时间: 2025.1-至今

指导:Dr.Tansu Celikel(美)

主要贡献:

1. 利用Python、C#语言独立开发了一套基于Senso.me手套(IMU)、OpenBCI的16通道肌电(EMG)、8通道脑电(EEG)和Varjo头显的多模态飞镖投掷VR训练系统,用于量化运动行为特征和多模态数据采集

2. 独立设计并制造了一款采用TPU材料3D打印的腕部固定器,用于稳定Senso.me手套(IMU)与OpenBCI肌电(EMG)的多模态输入误差,并通过集成阻尼系统,并结合回滞误差重校正方法,有效解决了IMU传感器的漂移问题

技能:C#, Python, Eye-Tracking, Signal Processing, Wearable Design